https://www.youtube.com/watch?v=WJRf7dh5Zws

面白かった。

solidjs, preact: ビルドなしモードが良さそう lit: 妙に評価が高いのが気になった

今日はさっさと寝る。23時就寝の習慣を取り戻す。(朝型化は時期尚早だった)

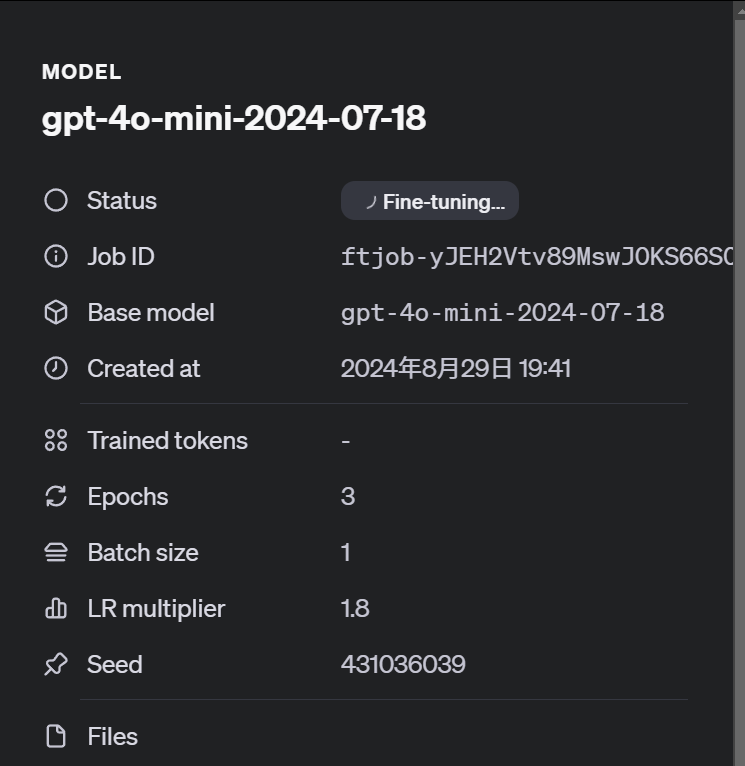

といいつつもったいないのでOpenAIのファインチューニングも色々したい。データを作るのが大変だけど。

振り返り、目標立てはいったん終わり。先月は進捗が全然だったので、今月はゲーム開発最優先で頑張る。

画像系をCDNでキャッシュするようにしたら多少読み込みが早くなった。

test2

test

月の振り返りを行う。

fastapiでなにか作ってみる

llamaだとシングルGPUでフルファインチューニングもできそう https://llama.meta.com/docs/how-to-guides/fine-tuning/

ファインチューニングモデルだと、データの傾向に従って長い出力をするようになったけど、後半部分がかなり怪しい感じになっている。対策としてデータのバリアンスを増やすのもありかもだけど、LoRA系の手法の限界もあるのかもしれない。

ある学習データは、約18万トークンだった。(システムやユーザープロンプト等は除いた純粋なデータのトークン数)

料金は以下の通りなので、

gpt-4o-2024-08-06: $25.000 / 1M training tokens ファインチューニングモデルの推論の料金: $3.750 / 1M input tokens $15.000 / 1M output tokens gpt-4o-mini-2024-07-18: $3.000 / 1M training tokens ファインチューニングモデルの推論の料金: $0.300 / 1M input tokens $1.200 / 1M output tokens (推論はバッチモードなら半額)

1エポックあたり、4oなら$3(450円)、4o-miniなら$0.6(90円) 3エポックなら、$9(1350円)、4o-miniなら$1.8(270円)

4oは、1日1Mトークン($25)まで無料。一日5エポック無料学習可能 4o-miniは2Mトークン($6)まで無料。一日10エポック無料学習可能 9/23まで。

ファインチューニング中。

エポック数は自動にすると、入力ファイルのバリデーションが済む前に3になっていた。学習過程のメトリクス等ではなく、データ量?に応じて決められていそう。

面白い。

時間がないので今日も進捗なし。

これで当分は手直しの必要はなくなったと信じたい。

改造終わり。

今日はmicroblogを軽く改造したらゲーム開発に移る。

test2

編集機能もほぼできた。

あとは

ハッシュタグを編集で追加したときにタグ検索結果に反映されないボタンがdeleteの隣にあって誤爆するのが怖い- → confirmしているから大丈夫だった

- Outboxにも簡単にUpdateを表示するようにしたい

- → 面倒そうなのでやっぱりやめる

new同様Ctrl+Enterでサブミットしたい更新時間も表示したい編集時のテキストボックスのデフォルトの大きさが小さいのを修正したい

が終わればOK。